Préambule

Aujourd’hui je vous propose un billet qui a pour finalité de vous inciter à voir un peu plus loin que les liens et à analyser les logs serveurs, conjointement à d’autres sources de données (WA, WMT, CA…), pour le SEO. Je vous le propose, au travers d’un exemple concret, un raisonnement suivi pour comprendre et résoudre un problème SEO sur un site. Je ne prétends pas maîtriser l’art d’analyser les logs et vous en faire l’étalage dans cet article. Ce n’est pas non plus une méthode de travail globale car je partage ici un cas d’une analyse bien précise sur un site.

Enfin sachez que j’ai limité cet article aux seules pistes qui ont directement fait avancer la démarche. Il faut donc le voir comme un résumé. On pourrait aller beaucoup plus loin et relever bien plus de données mais ce n’est pas le but ici.

J’avoue que j’ai pas mal hésité avant de publier cet article car je suis plutôt dans l’optique d’en dire peu sur la manière dont je travaille mais un certain Aurélien Berrut, auteur de l’excellent Htitipi.com, m’a fait réfléchir. Je réagissais à un de ses articles en disant que je trouvais qu’il en disait trop sur un blog public et il m’a répondu que c’était bien plus bénéfique que ce que je pensais. Voyons ça :)

Problématique de départ

Je vais prendre le cas d’un client dont le trafic SEO baisse depuis quelque temps. Il m’a laissé une piste : il a mis en place une série de pages de « contenu » dont le seul but était en fait de générer du trafic SEO. Les pages sont très, très optimisées et assez pauvres en contenu réel et unique (on ne fait pas toujours de miracles avec du spinning).

Pour faire simple, ce sont des pseudo landing pages SEO entièrement automatisées. Si elles ne génèrent pas a priori de duplicate content pur*, elles ont pour particularité d’avoir une durée de vie limitée (les informations contenues dans ces pages ont une très faible durée de validité). Une fois l’information périmée, la page est tout simplement effacée et « remplacée » par une redirection 301 vers une page univers.

* Si Google est performant dans l’analyse de l’empreinte d’un texte c’est cuit puisque ce ne sont que des spuns alimentés par des variables en base.

J’ai volontairement orienté mon travail sur la recherche de la cause de cette baisse de trafic progressive et donc sur l’analyse de ces pages.

Préparation des données

Extraction des données utiles

J’ai dans un premier temps extrait des logs la seule activité des bots Google (ensemble de bots qu’on appellera Googlebot par la suite pour que ce soit plus digeste) car mon but est bien ici de me concentrer sur le seul comportement de crawl. J’ai limité l’analyse à quelques jours (du 13 au 19) afin de pouvoir générer rapidement les traitements de données mais j’aurais pu le faire sur une plus large période. Dans bien des cas il est très utile de ne pas limiter vos analyses aux logs générés par les robots, par exemple pour détecter les pages générant de l’activité sans toutefois attirer de visites SEO.

On peut également se lancer dans des études aussi passionnantes qu’utiles en croisant les données de logs avec des crawls du site par un outil interne, les données de web analyse et les données business. Je n’ai, à ce jour, pas d’outil suffisant pour pouvoir y parvenir mais la vie est longue et je ne désespère pas de trouver :) Certaines solutions d’analyse de logs et de crawl arrivent sur le marché, attendons la sortie de ces outils avant de nous prononcer.

Catégorisation des URL

Pour bien analyser un site il faut impérativement en catégoriser les URL, ce qui donne par exemple :

- fiche-([0-9].+)\.html => Fiches produit

- cat-(.*)-([0-9].+)\.html => Catégories

- Etc.

La tâche n’est pas toujours évidente : il faut bien comprendre et connaître le site pour pouvoir le faire. Vous verrez par la suite que c’est très utile sinon indispensable pour pouvoir tirer des actions concrètes des analyses (ce qui est tout de même le but de la manoeuvre).

Pour ma part je catégorise sur deux à trois niveaux. (Fiche produit // Univers // Rayon par exemple) pour pouvoir affiner les analyses mais comme je fais tout à la main c’est assez chronophage.

Analyses et constatations

Nombre de hits Googlebot par jour (global et par header)

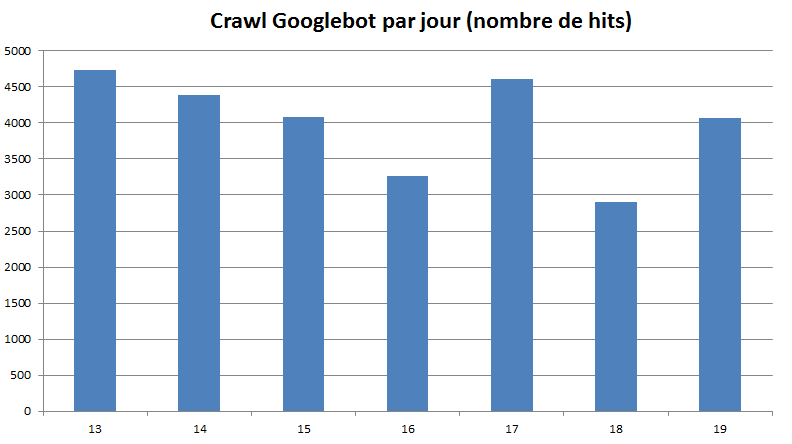

Ma première étape a été de constater le nombre de hits (non uniques) générés par Google sur le site chaque jour (ici filtrés sur les seuls 200). On obtient une moyenne de grosso modo 4000 hits en 200 par jour. J’aurais du remonter jusqu’à un mois avant la mise en ligne de ces fameuses pages SEO mais les logs n’étaient pas disponibles.

Ce rapport ne dit rien de spécial mais il est utile de le suivre sur de grande périodes pour voir les tendances : à la hausse, good job, à la baisse, alarmez vous s’il n’y a pas de justification immédiate !

Quelques lignes plus haut je vous ai parlé de catégorisation d’URL. C’est ici que ces données se révèlent indispensables car elles permettent de générer un graph plus utile : la répartition du crawl par catégorie. Malheureusement je n’ai pas gardé le graphique généré. Ce qu’on pouvait y voir, c’est que la majeure partie du crawl du site (68%) se fait sur … les pages que le client a justement créé pour le SEO et qui m’ont alerté dès le début. Tiens donc.

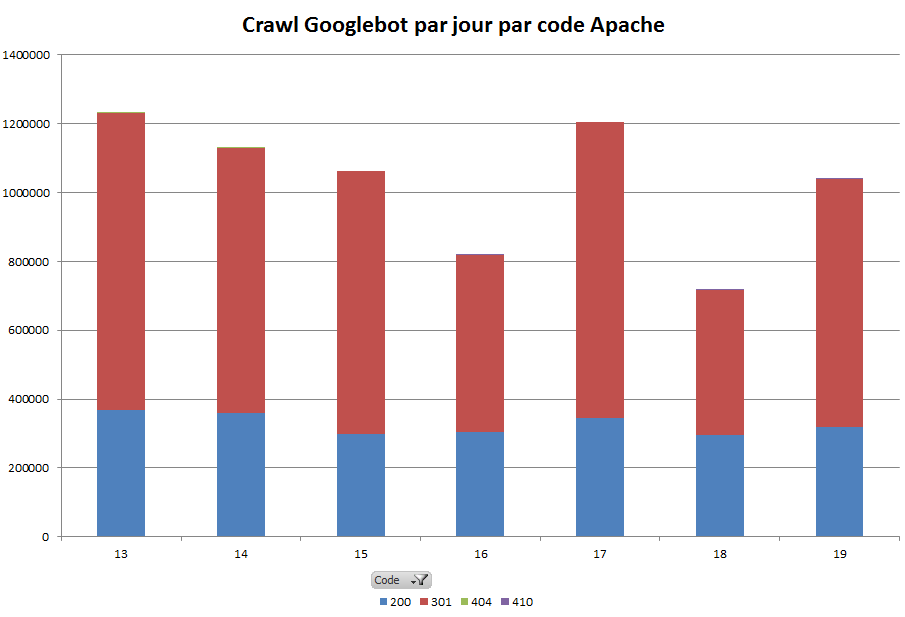

A défaut de pouvoir vous présenter ce graphique, avançons et regardons le suivant, très intéressant également. Il permet de confronter les différents types de codes rencontrés par les robots sur cette même période. Le constat est édifiant :

On peut voir immédiatement que si le site semble très bien gérer ses liens (pas ou peu de 404), les header 301 sont extrêmement présents. Ils sont supérieurs aux 200 ! C’est la première fois que je constate une chose pareille à l’échelle d’un site.

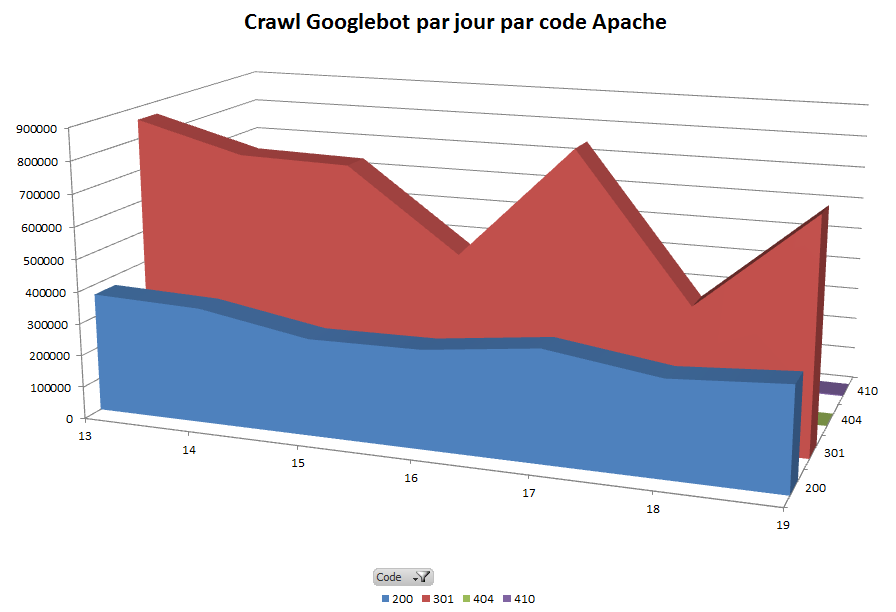

Pour prendre mieux la mesure de la situation, j’ai généré une autre vue, cette fois-ci en 3D, qui à mon sens met bien en avant le souci (personnellement je trouve ça plus parlant) :

Il semble clairement y avoir un souci quelque part et il faut absolument analyser ce qui se passe. Google se mange quasiment deux fois plus de 301 que de 200… tout en sachant qu’une 301 suivie mène sur un 200 à la fin. Entrons un peu dans ces 301 pour voir d’où elles viennent.

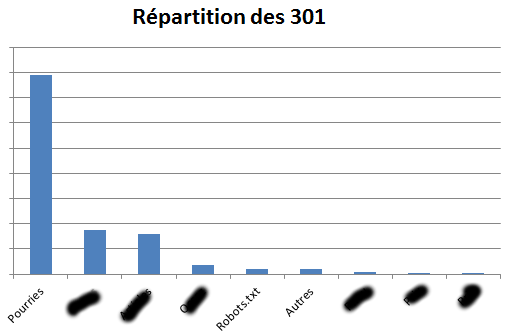

Focus sur les 301 par catégorie

Là encore la catégorisation des URL va nous servir.

J’ai masqué les noms de catégories d’URL, imaginez que derrière les pâtés noirs se trouvent :

- Pages univers

- Pages catégorie / rayon

- Pages CMS

- Landing SEO

- Etc.

Le nom « Pourries », je l’ai justement donné à ces pages créées par le client pour booster le SEO de son site. Avant d’analyser les logs je ne pensais pas du tout qu’une des causes de leur contre-performance serait celle de générer des tonnes de 301. J’ai mis le doigt sur quelque chose d’intéressant.

Nos pages puantes, en plus de monopoliser le crawl sur le site, génèrent énormément de redirections 301.

Alors quoi, on les vire ?

Allons-nous pour autant couper directement tout lien interne vers ces pages et leur couper totalement le crawl ? Pas trop vite ! Il faut avant cela se poser les bonnes questions (liste non exhaustive) :

- Ces pages ont-elles un intérêt pour les visiteurs ?

- Ces pages apportent-elles du trafic ?

- Ces pages génèrent-elles du business ?

- Ces pages alimentent-elles la structure en Page Rank depuis l’extérieur ?

- Ces pages poussent-elles des pages clés en interne ?

- …

Je vais juste m’intéresser ici aux points 2 et 3.

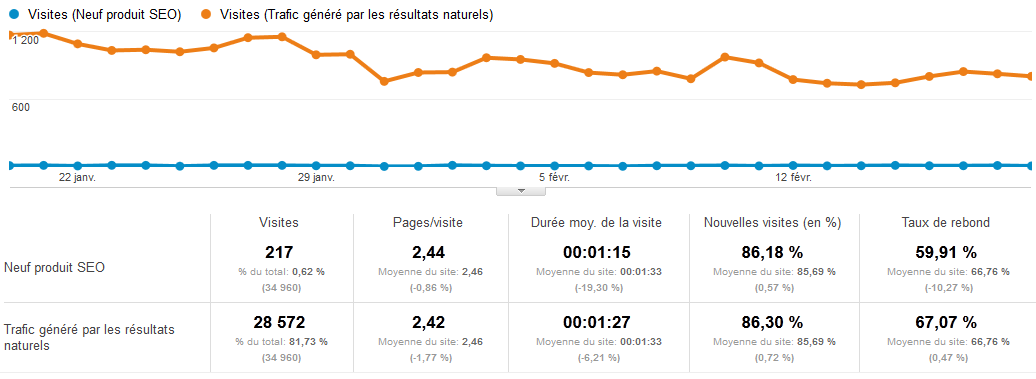

Analyse du trafic des pages concernées

Je me base sur un simple rapport Google Analytics Contenu > Pages de destinations sur un segment SEO global (marque et hors marque confondus). Si j’avais les logs au complet j’aurais aussi pu très facilement obtenir ces informations en termes de nombre de visites.

Ouch. Résumons nous. Les pages magiques censées booster le SEO :

- Consomment 68% du crawl quotidien

- 44% des hits se soldent par des redirections 301 pointant vers d’autres sections du site

- Génèrent … 0.62% du trafic SEO global du site

Pour autant, on voit que le nombre de pages par visite, la durée moyenne de visite et le taux de rebond ne sont pas en décalage avec le reste du site (même si les stats sont mauvaises).

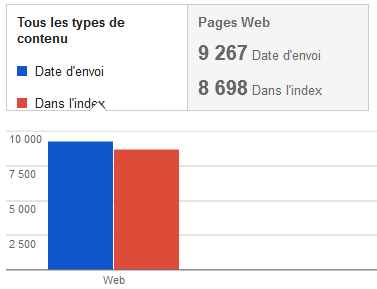

Quel est le taux d’indexation de ces pages ? Beaucoup de crawl, peu de trafic, pages pourtant optimisées. Il est intéressant de se demander si elles sont … indexées ! Et si oui, le sont-elles majoritairement ? Voici ce que dit Webmaster Tools pour ces pages :

A première vue, Google indexe 93% de ces pages mais dans notre situation ce chiffre ne veut rien dire. Ce qu’il faudrait faire c’est :

- savoir pourquoi 100% n’est pas atteins (vu la taille du site, ce devrait être le cas)

- savoir le nombre d’URL uniques crawlées chaque jour pour cette typologie de page

- savoir le temps qui s’écoule entre le crawl et l’indexation de ces pages

- scrapper les SERP à un instant T et comparer la liste des URL indexées avec la liste des URL présentes dans l’arbo le même jour

- …

Ainsi, on saurait si le robot aurait la capacité, chaque jour, de crawler, indexer et faire ranker toutes ces pages. Actuellement, c’est loin d’être le cas.

Pour autant, il faut encore analyser un point : ces pages sont-elles qualitatives ou incitatives pour l’internaute ?

Qu’en dirait mon banquier ?

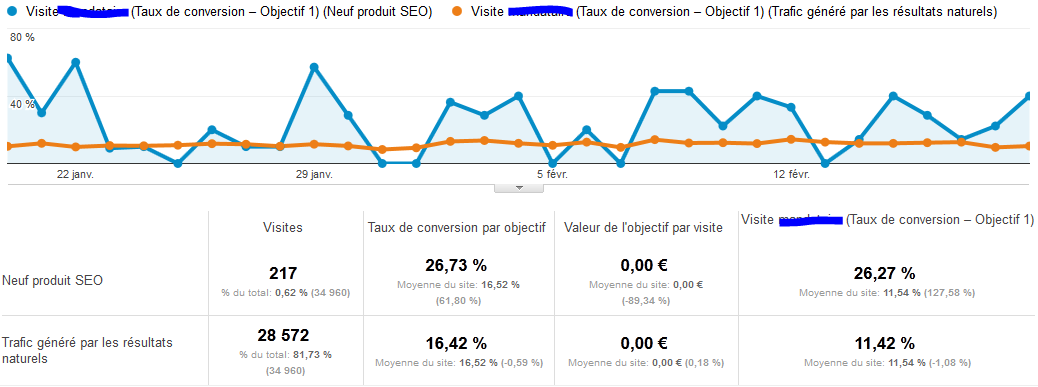

Ces pages sont-elles génératrices de business ? Après tout, on gère le SEO d’un site, on le travaille, on passe du temps, mais la finalité est bien de faire de la marge nette. A défaut de pouvoir pousser l’analyse aussi loin, voyons si ces pages ont un intérêt dans la conversion sur le site :

Le taux de conversion sur ces pages est plus de deux fois supérieur à celui de l’ensemble du site sur le segment SEO. Cela confirme l’intérêt que ces pages peuvent avoir pour le visiteur et pour la conversion. Voici de quoi alimenter la réflexion sur ce qu’on peut en faire.

Qu’avons nous appris ?

Nous avons pu découvrir que ces pages censées être magiques consomment une part non négligeable du crawl du site chaque jour, que la plupart des hits des robots se soldent par des 301 et que dans le même temps ces pages ne génèrent que très peu de trafic. Toutefois, le trafic qui y tombe est qualifié et aide à la conversion.

Nous avons également appris que nous n’aurions pas obtenu ces données en faisant des rapports de positionnement, ni en auditant le linking, ni en crawlant le site, ni même en analysant les statistiques.

Quelque chose me dit qu’il vaudrait mieux, dans un premier temps et avant d’envisager de les supprimer, essayer de trouver comment mieux mettre en avant ces pages, et comment les rendre plus compatibles avec le SEO.

Au final je pense que tout mène vers le fait que :

- Soit ces pages ont une durée de vie trop courte. Si elles étaient plus pérennes, il y aurait beaucoup moins de 301, il y aurait moins de crawl (on pourrait d’ailleurs mieux l’optimiser) et toutes seraient indexées

- Soit elles ne reçoivent pas assez de Page Rank

Comment continuer l’analyse ?

On a pu voir dans cet exemple très concret et précis que l’analyse des logs, cumulée à celles d’autres sources de données, peut vraiment aider à déceler et résoudre des problèmes pour le SEO sur un site.

L’analyse est loin d’être terminée et il faut certainement suivre les pistes suivantes :

- Pour pousser l’analyse :

- Se demander pourquoi ces pages n’obtiennent pas de positions intéressantes dans les SERP

- Dédoublonner les hits sur ces 301 pour savoir si le souci touche un faible nombre de pages ou toutes

- Vérifier le Page Rank de ces pages et les liens pointant vers elles (et en tirer les conclusions qui s’imposent, je n’en dis pas plus)

- Analyser la fréquence de crawl par jour sur les pages puantes

- …

- Pour régler le problème :

- Rendre ces pages plus pérennes

- Améliorer le maillage interne pour apporter plus de Page Rank à ces pages et les aider à en redistribuer plus

- Envoyer plus de Page Rank externe à ces pages (linking)

- Améliorer la fréquence de crawl sur les pages puantes

- …

Et si j’avais été un excité du linking ?

Si je n’avais jamais consulté les logs, qu’aurais-je fait ? J’aurais fait les mêmes constatations sur le trafic et la conversion, et j’aurais axé toute mon énergie sur la création de liens externes vers cette typologie de pages puantes. J’aurais certainement réussi à gagner un peu en trafic mais je n’aurais pas réglé les problèmes concernant la trop faible durée de vie des pages et n’aurais probablement pas pu voir qu’elles pénalisent potentiellement tout le site.

En fait, je pense que le plus efficace sera de trouver d’abord une solution au problème et d’apporter ensuite le linking nécessaire.

Le fin mot de l’histoire

Analysez vos logs ! Comme moi, passez pour un dingue auprès de vos collègues qui ne travaillent pas dans le SEO et qui croient vous voir « communiquer avec Google » quand ils passent devant votre écran remplis de lignes de logs. Analysez, décortiquez, tentez de comprendre Google.

Ca prend du temps, c’est au début assez déprimant (on pensait avoir un site au top et la réalité est toute autre), ça demande de l’énergie et de la passion mais quand on maîtrise les bases comme c’est à peine mon cas, on s’éclate.

Vous avez aimé cet article ? Peut-être que vos contacts l’apprécieront ! N’hésitez pas à le Twitter et Plusser !

Tout commentaire sera apprécié tant qu’il n’est pas là pour « chopper du backlink » (nofollow soit dit en passant) et qu’il contiendra le mot kracaplouf, pour prouver que vous avez bien lu l’article, au moins jusqu’ici. J’ai découvert cette astuce grâce à Sylvain Fouillaud, alias Noviseo, qui a utilisé cette astuce sur un de ses articles. J’ai trouvé ça très malin. En tout état de cause, participez à ce billet, apportez votre vision.

Merci de m’avoir lu, au plaisir de lire vos réactions ;)

Remerciements

Tiens, des remerciements. Ils n’ont pas vraiment de lien direct avec cet article mais je tenais à les placer quelque part. Je tiens à remercier chaleureusement deux personnes qui, sans le vouloir, sans le savoir, sans en avoir eu l’intention, ont donné un véritable sens à ce genre d’analyses que je faisais parfois pour le SEO de mes sites ou de mes clients.

Jusqu’à leur rencontre, qui a du durer une petite demi-heure au plus, je le faisais de manière totalement artisanale et pensant être un peu en dehors du cadre de mon métier. Je pensais être à l’écart d’une communauté SEO obsédée par le linking. Je pense bien entendu énormément de bien des liens externes et je sais à quel point ils sont puissants dans une stratégie SEO, mais sur une base saine.

En rencontrant ces deux personnes, j’ai appris que certaines sociétés tiraient énormément de bénéfices (SEO) à travailler cet axe du SEO. Bien évidemment, cette dreamteam doit le faire avec un professionnalisme et une qualité d’un tout autre niveau, mais ça m’a donné envie de professionnaliser ma démarche. J’ai appris par la même occasion que le « white hat » pouvait être ultra technique, ultra qualitatif et pouvait nécessiter une très grande expertise.

Merci donc à Jean-Benoit Moingt et à Medhi Moreau d’avoir prononcé quelques phrases magiques qui ont éveillé ma curiosité.

Abonnez-vous au flux flux RSS | You can skip to the end and leave a response. Pinging is currently not allowed.

Mazette ! Quel billet !

Si tu perds des prospects avec un tel article, c’est qu’ils arrivent à le digérer et qu’ils ont un niveau largement suffisant pour gérer leur SEO en interne.

Sur le fond, je kiff ! Ca me rend tout kracaplouf ;-)

Plusieurs choses me sont venues à l’esprit :

Le volume de 301 est incontestablement trop élevé au regard des codes 200. L’analyse du bot est extrêmement fine et riche d’enseignement dans cette étude de cas. Il y a, à mon avis, plusieurs écoles quant aux stratégies à mettre en place pour redresser les courbes. Me concernant, j’introduirai progressivement les erreurs « gone » 410 (surtout pas 404) sur les pages les plus moisies pour diluer les 301, et arriver in fine à un meilleur équilibre. Augmenter la pérennité de ces pages comme tu le suggères tout en diminuant la fréquence et le volume.

Enfin je suis très surpris que le nom de Botify n’apparaisse pas dans cet article… c’est volontaire ? Il me semble d’ailleurs avoir vu passer un tweet de ta part faisant un teasing là-dessus… J’ai peut-être loupé un train, un peu débordé en ce moment…

Encore bravo, je partage et je mets le billet dans mon pocket pour le relire encore plus tard car il mérite plusieurs lectures pour être assimilé et apprécié comme il se doit.

Bonjour et merci Aurélien, ça fait plaisir.

Le nom de Botify n’est pas présent dans ce billet car ils fera tout simplement l’objet d’un billet à part. C’est encore mieux pour eux. Toutefois, il n’y a rien dans cet article et dans ces analyses (qui ont été faites il y a quelque temps) qui sorte de Botify ni d’un autre outil du marché. J’ai tout fait moi même, avec mes bouts de bois et mes silex :o) Je ferai un billet sur Botify et consorts (je suis en test de plusieurs outils) quand l’analyse sera terminée et fiabilisée car pour l’instant nos premiers tests ne sont pas exploitables.

Il n’y avait donc pas lieu de les citer ici, mais pas de raisons non plus de taire leur nom.

Pour les 410 j’ai un avis très mitigé. J’ai fait beaucoup d’essais et Google les crawle encore et toujours, sans cesse. Si en théorie c’est une solution intéressante, en pratique je n’arrive pas vraiment à économiser beaucoup de crawl avec. En tout cas je n’économise pas de hits (en time taken & BP c’est bien sur plus efficace qu’une cascade 301 > 200).

De plus, avec une 410, je vais supprimer la page.

Belle démo ;-)

L’analyse de logs et la simu de crawl est un exercice vital, mais extrêmement délicat.

J’ai observé des décisions qui ont bénéficé un site et d’autres qui ont été désastreuses. En l’occurrence, je pense surtout aux pages « pourries ».

En fait, c’est toujours l’histoire du verre à moitié vide ou à moitié plein.

Fastoche d’analyser qu’une portion plus ou moins importante du site présente une faible valeur ajoutée.

Du coup, la tentation de les saborder émerge.

L’autre solution consiste à apporter de la valeur ajoutée à ces pages considérées comme « pourries ».

En passant, un élément que je prends toujours en compte est la date du dernier crawl de Google ou simplement du cache. Si c’est supérieur à 30 jours, la page est dead.

PS : je suis également un grand fand du kracaplouf !

Merci Laurent. Oui j’ai vu que tu parlais souvent de cette notion de dernière date de crawl. Pour ma part je suis moins souple et je pense qu’une page non crawlée sur les 15 derniers jours présente un vrai problème… à moins que ce ne soit le site qui en ait un… ou les deux.

Comme tu le soulignes bien, l’analyse est une chose, les conclusions en sont une autre, très complexe. Et pour finir, si on a réussi à faire tout ce chemin, il reste la mise en pratique qui nécessite quasi obligatoirement des modifications lourdes : changement fonctionnel, structurels, développement, etc.

Passionnant ! Nous avons vraiment la chance de faire ce métier. Pour ma part je n’ai jamais l’impression de bosser, sauf quand je dois faire un master spin mais ça c’est une autre histoire.

kracaplouf :-)

Bel article, merci pour la dédicace.

Il faudra que je te montre ma machine de guerre un de ces jours.

Attention à la catégorisation qui manque un chouilla de rigueur ;-)

Avec plaisir pour ta machine de guerre. Je serai bientôt sur Paris je te contacterai.

Pour la catégorisation tu as surement raison. Sache que je l’ai ici simplifiée pour bien mettre en avant le problème mais comme dit dans l’article je catégorise habituellement sur 3 niveaux. Ainsi tout ce qui est robots.txt, sitemap.xml etc est dans Autres, le produit d’une catégorie lui est rattaché, etc. Ca permet d’avoir les analyses sur 3 dimensions et ou en combinant les dimensions. Egalement, les « regex » que j’ai mis dans l’articles sont inventées pour le besoin de l’exemple.

Mais il y avoir encore beaucoup à faire pour avoir quelque chose de précis. Yannick Simon m’a évoqué une petite idée qui n’est pas tombée dans l’oreille d’un sourd ;)

C’est ce qu’on appelle un excellent article : l’analyse est pertinente et met en avant un point pas assez travaillé en SEO.

Concernant sur ce que tu dis sur le fait d’avoir eu pour la première une site qui fait plus de codes 301 que de codes 200, j’ai malheureusement eu plusieurs fois le cas, et il est toujours dur de se débarrasser de ses vieilles casseroles.

Sur un site ecommerce par exemple, un mauvais système de permaliens dupliquait à l’infini les URL. Au lieu de retrouver mes 2000 pages de contenus et mais mes 1000 images, Google détectait plus de 500 000 URL en tout. Et même en ayant réparé le tout il y a deux ans, le serveur continue de renvoyer bien plus de codes 301 que de codes 200 (mais parvient quand même à se positionner).

(Edit : pas de krakaplouf, pas de liens)

Ce que je voulais dire c’est qu’en mettant comme regex :

fiche-([0-9].+)\.html

Tu ne vas potentiellement pas voir

fiche-12345.html?print=ok&machin=truc…

On préférera :

fiche-([0-9].+)\.html$

Bonjour,

Je vais passer pour le novice de passage (ou le kracaplouf) mais bon en même temps c’est un peu ce que je suis.

Donc, ce que j’ai mal à capter c’est comment tu arrives à la conclusion que le problème vient (entre autres) vient de la courte durée des pages pourries? Est une intuition de ta part, une hypothèse?

Sinon, bravo et surtout merci du partage ou plutôt de cette contribution. Je pense que c’est la bonne attitude ,)

Laurent

Wawww… il va me falloir le relire encore quelques fois avant de percuter toutes les subtilités…

Peu importe, un article vraiment passionnant – en pleine cérémonie des césars, pourtant – je kiffe moi aussi !

Et vivement le prochain (avec un peu kracaplouf).

Excellent article ,

On ne croise pas souvent cette thématique alors qu’il n’y a rien de plus fiable que les logs ;)

Petit kracaplouf : ça aurait été sympa de mettre de préciser le nom du logiciel utilisé pour tes lecteurs

Bonjour et merci François-Olivier pour ce partage..et les commentaires d’experts !

@Seosix je renvoie sur cet article qui date un peu mais très utile sur les méthodes d’analyse de crawl : http://searchenginewatch.com/article/2063967/Technical-SEO-Tools-and-Approach

En revanche, si après avoir lu ce post la foulkracpa pour le seo, je comprends plus rien ;) !

@Lauent

Bonjour,

Je t’invite à relire l’article bien à fond car j’explique dedans comment j’arrive à cette conclusion. En fait ces pages, une fois périmées, génèrent une 301 vers d’autres pages du site, qui elles sont bien en 200 et pérennes.

@Seoxis

Bonjour,

Merci. Je pense en avoir déjà dit pas mal ;o) Libre à chacun d’utiliser ses outils et ou de les développer.

@Maurice

Bonjour, merci pour ton commentaire. Pour le lien, il présente effectivement quelques pistes de logiciels que l’on peut utiliser pour crawler son site.

Je viens de lire 3 fois ton article pour bien comprendre ta reflexion et ta méthode de fonctionnement dans l’analyse des logs et tout ce que je peux dire c’est IMPRESSIONNANT !!!

Je ne suis qu’une modeste SEOGirls qui commence petit à petit à se perfectionner dans l’analyse onsite avant de passer au offsite.

Je suis perfectionniste et j’aime faire les choses dans l’ordre et surtout les faires bien.

Je suis une novice dans l’analyse des logs et en soif d’apprendre donc j’ai quelques questions (si tu veux bien y répondre ;) ):

- Comment te procure tu les logs ? J’ai vu qu’on pouvais trouver le ficher de log via un chemin spécifique (/var/log/apache2/access/nomdusite.log) mais je ne sais pas trop où chercher et je ne le trouve pas sur le ftp (serveur mutualisé et dédié).

D’autre part je susi allé sur le logiciel AWStats et Urchin qui me donne les visites des bots mais c’est assez basique je ne pense pas que ce soit la bonne méthode.

- Une fois en possession de ce fichier comment extraire son contenu et surtout identifier les crawls de GoogleBot ?

- Peut-on analyser les logs de la même façon sur un serveur dédié que sur un serveur mutualisé ?

Je sais que le serveur mutualisé donnera moins d’infos mais puis-je quand même sortir des données précises ?

- J’ai vu que pour l’analyse des logs tu utilisais excel mais comment fait-tu pour passer des lignes de code du fichier de log au tableau de données ? bon là je ne sais pas si tu repondra à cette question car d’une part c’est ton expertise et d’autre part cela prendrai je pense beaucoup de temps mais bon qui ne tente rien n’a rien ;)

Enfin si tu as de sources intéréssante pour que je me perfectionne dans l’analyse des logs je suis preneuse ;)

Merci beaucoup pour ton article

Bon WE

@Julie

Bonjour,

Merci pour ton commentaire. Google, patience, essais, échecs, réussites, illusions, désillusions. C’est comme ça que tu auras tes réponses.

En tout cas c’est comme ça que j’ai fait ;)

Pour analyser les logs, vous pouvez aussi utiliser Piwik le web analytics open source, qui permet d’importer les logs et analyser les requetes 200 / 301 / 400 etc. http://piwik.org/log-analytics/

Très bon article, qui le met à niveau égal à ce qu’on peut voir sur les blog US. La npotion de date de cache est très pertinente mais peu discutée dans la sphère francophone (comme anglophone). Si une pages est intéressante elle sera régulièrement crawlée (pourquoi? je ne sais pas peut être pour voir si de nouveaux coms sont sorti, parce qu’il y a des liens nouveaux qui pointent).

Article très intéressant qui a le bénéfice de formaliser comment faire une analyse de logs pertinente !

La seule limite que je vois a cette analyse est le volume de datas, dans cette étude de cas le volume de données est relativement faible. Ce la fait plusieurs moi que je recherche un outil qui puisse gérer des millions de lignes.

Si quelqu’un en connait un qui ai un qui se configure facilement dons l interface et user friendly, je suis preneur ! J’ai entendu parlé de http://www.splunk.com/ mais le prix est assez élevé !

Excellent article mais tu as oublié de dire merci au client sur qui tu peux faire tes expériences :)

@PH : Bonjour. Oui ici le volume est faible mais il ne faut pas oublier qu’on parle de la seule activité de Google Bot au sens large.

Pour ton info ce sont des extraits des logs d’un site qui fait 10 millions de visites par an en moyenne, mais sur seulement 60 000 pages, donc un site de taille moyenne.

Plus le volume de données monte, plus j’imagine qu’il faut adapter ses méthodes mais je n’ai pas de tels sites à analyser.

Vu les vitesses de mes traitements, je dirais que ma méthode peut accepter 10x plus de données sans trop broncher.

Au delà il y a d’autres outils qui seront plus adaptés. Regarde du côté des analyseurs de logs open source en bash.

@leclient : Hello, tsss tu ne m’écoutes pas assez. Lors de notre réu de Lundi je t’ai dit que j’avais fait ces analyses sur un autre site, qui m’avait permis de trouver une piste pour le votre ;) Ce n’est donc pas votre site.

A très vite !

Hello,

Cette méthodologie a été créé par les fondateurs d’une société française en 1999, qui continue d’appliquer cette méthodo et de développer des outils dans un objectif SEO purement whitehat…

Les personnes citées, dont je tiens à souligner les qualités et compétences ayant également fait un passage par cette structure ou ayant été en contrat avec celle-ci…

Cette méthode de crawl de site et de croisement avec les logs est la seule éprouvée pour étudier des sites de dizaines de milliers à plusieurs millions d’url…

Appliquez cette méthodologie, pour la santé de vos sites, je n’en dirais pas plus:-)

@gucky

Bonjour Gucky,

Merci pour ton commentaire. Que ce soit très clair, puisque ça ne doit pas l’avoir été dans l’article : je ne prétends pas avoir inventé une quelconque méthode mais j’affirme que je l’ai acquise moi même. Les deux personnes que je remercie dans cet article m’ont seulement dit qu’ils travaillaient (notamment) de cette manière, et c’est tout.

Ce que j’ai dit en fin d’article c’est que discuter avec eux a donné du sens à cette méthode que j’ai expérimenté dans mon coin et pour mes clients sans savoir si c’était une pratique courante ou au moins suivie par certains référenceurs. En ayant appris que c’était le cas, j’ai investigué plus loin, encore une fois sans avoir jamais pris d’informations ni même avoir été « formé » par des actuels ou anciens clients ou salariés de cette agence.

Je ne me suis rendu compte, par hasard, que quelque temps après cette rencontre que c’était une méthodologie fondatrice chez Aposition, société dont j’ignorais tout il y a encore 6 mois, honte à moi, je sais (mais pour laquelle il doit être absolument passionnant de travailler).

Quelque part c’est flateur, ça veut dire que j’ai trouvé par moi même un mode de fonctionnement très pertinent ;)

Je suis, depuis quelques mois, parti à la recherche d’outils pour traiter mieux, plus vite, plus de données mais je cherche encore. C’est la raison pour laquelle le nom de Botify a été cité un peu plus haut dans les commentaires, et que je teste actuellement Mitambo avec les excellents frères Lamotte.

Bref, le remerciement voulait juste dire « merci d’avoir prononcé les deux phrases qui m’ont fait tilt et merci pour leur gentillesse ». Quand on a de tels niveaux et à un tel niveau de responsabilité, rester aussi abordable et sympathique est une vraie prouesse.

Parole d’ancien RRH (que je suis) !

Très bon rappel merci je me sens moins seul !

Bonjour, très bon article. Étant nouveau dans le monde de référencement, j’ ai encore du mal à comprendre certains points mentionnés dans ton article. J’espère y parvenir bientôt:)

je suis impressionné par le type de conclusion que l’on peut avoir à travers l’analyse de logs.

L’autre jour j’en discutais avec une des personnes qui avait assisté à la Formation Watussi -qui je crois aborde abondamment la notion d’analyse de logs, et j’avais compris que cette technique était intéressante surtout pour les gros sites, du fait du besoin d’avoir un nombre conséquent de jeux de test, afin d’avoir une tendance et de tirer des conclusions.

Bref, je suis tenté de faire ça mais je m’interroge d’abord sur sur la nécessité de le faire (même si tu as démontré que c’était très utile). Il me faut surtout une opportunité.

ps : personne ne m’obligera à écrire un quelconque mot. Personne. Personne. Mais dans mon spamco, tu dois avoir toutes les lettres qui le composent. Okay ;)

Pas evident de tout comprendre quand tu es novice comme moi sur l’analyse de logs mais captivant comme article ! Surtout qd c’est la communauté lilloise qui s’en charge ! :) J’ai deja installé la version gratuite de watussybox mais c’est pas simple à analyser. Aurais-tu quelques site, tutos a communiquer pour en connaitre d’avantage sur les logs ?

Merci

Hello ami Lillois,

Le mieux c’est de les faire développer et de bien se creuser le crâne pour savoir quelles requêtes sortiront des choses intéressantes. La data c’est bien mais il faut bien l’exploiter :)

Hello,

Super article, vraiment très intéressant !

Il date de février 2013 mais est toujours utile pour les personnes comme moi qui débutent dans l’analyse de logs et qui cherchent des infos concrètes.

Merci et kracaplouf ^^