Préambule : pourquoi cet article ?

J’avais préparé cet article il y a quelques mois puis je l’avais laissé trainer, non terminé, sur ma Dropbox. J’ai eu l’idée de le ressortir après avoir constaté que beaucoup de référenceurs s’emmêlaient les pinceaux à propos du robots.txt. Ces incompréhensions peuvent les amener, sans le savoir, à prendre de mauvaises décisions. Je vous invite vraiment à lire cet article même si, à première vue, vous pensez connaître le fonctionnement de cet outil. Je suis sur (en tout cas j’espère !) que vous apprendrez quelque chose… ou que vous m’apprendrez quelque chose en commentaire.

On lit par exemple souvent, à tort, que Google ne fait « qu’à sa tête du robots.txt ». La justification couramment admise est de dire que « ça ne fonctionne pas car Google indexe tout de même les pages bloquées ». Nous verrons pourquoi ces deux affirmations sont fausses.

Pour pouvoir être exhaustif et ou expliquer certains points, je dévierai un peu sur certains éléments qui gravitent autour du robots.txt, de près ou de plus loin.

Je suis loin de prétendre tout savoir alors vos commentaires, rectifications ou précisions suite à la lecture de cet article sont les bienvenus. Utilisez votre nom ou votre « nom de scène » pour que l’on puisse vous identifier. Les EMP (exact match pseudos) seront renommés « Anonyme » et seuls les commentaires directement liés à l’article et apportant des précisions, ou posant des questions sur l’article seront validés.

A la suite du commentaire de Jean-Benoît et après discussion avec Aymeric, j’ai fait des tests complémentaires concernant la directive Noindex: présentée dans cet article. J’ai ajouté une directive dans le robots.txt (Noindex: /mapage.html) ai j’ai attendu que Google crawle le robots.txt et le mette à jour dans Webmaster Tools.

J’ai lancé un « Explorer comme Googlebot » sur l’URL en question et là… surprise. Google indique que la page ne peut pas être crawlée car elle est bloquée par le robots.txt :

De plus, aucune ligne du passage de Google pour cette page dans les logs : il n’a réellement pas voulu crawler la page. Il semble donc que Noindex: soit une combinaison de noindex et de Disallow. On peut d’ailleurs le lire sur cet article (en Anglais).

Dès lors, faites très attention à ne pas bloquer des pages maillées en structure ou depuis l’extérieur avec une directive Noindex. L’article a été mis à jour, vous pouvez le lire sans craintes :)

Différence entre crawl et indexation

Pour bien comprendre comment fonctionne le robots.txt, et pour pouvoir constater son efficacité, il faut distinguer les notions de crawl et d’indexation, car ce sont deux choses bien différentes. La plupart des mauvaises interprétations du fonctionnement et de l’efficacité du robots.txt partent de l’incompréhension des différences ces deux notions.

La notion de crawl (exploration)

De manière vulgarisée, le crawl d’une page est l’étape qui consiste à télécharger un contenu pour en extraire les informations qui serviront à :

- nourrir l’algorithme à partir d’informations calculées et ou récupérées dans la page

- faire la liste des liens contenus dans la page

- … établir une liste des URL à visiter une fois l’exploration de l’URL en cours effectuée

- etc. Puis on recommence

Crawler une page, c’est donc la lire et extraire tout un tas de données. Crawler un site, c’est effectuer cette action de pages en pages.

La notion d’indexation

L’indexation consiste à inclure une URL dans l’index, pour qu’elle puisse être présentée dans les résultats de recherche (SERP).

La notion de positionnement

Le positionnement, c’est la place qu’occupe une page dans les résultats de recherche (SERP) pour une expression donnée.

Robots.txt : un outil pour gérer le crawl (mais aussi… l’indexation)

Le positionnement d’une page dépend de tout un tas de facteurs que nous essayons tous de comprendre, parfois de manipuler, pour apporter un maximum de trafic qualifié aux sites de nos clients. Ce qu’on admet communément, c’est que pour le positionnement, « Google » se base sur le contenu de la page, sur le contenu des pages « autour » de celle-ci (qu’il soit interne ou externe au site), sur les ancres de liens, leur contexte, sur des critères de qualité de trafic (voir un article que j’avais écrit sur le sujet en 2010), etc.

Si je rappelle tous ces éléments, c’est pour expliquer un phénomène parfois un peu troublant : le fait que des pages puissent être indexées alors que les directives du robots.txt en interdisent le crawl.

En effet, les moteurs utilisent tout un tas d’informations dont le contenu de la page elle-même. Dès lors, rien ne les empêchent d’indexer la page sans avoir pu en lire le contenu. Google prend bien sur des risques à le faire puisque dans une telle situation, il ne connait pas le contenu exact de la page en question mais uniquement ce que les autres sites en disent (à travers les liens). Il ne sait pas non plus si la page en question est encore bel et bien vivante. Cette prise de risque explique pourquoi il est rare que des pages indexées sans qu’elles ne puissent être crawlées soient bien positionnées, mais ça arrive.

L’exercice revient au même que lorsque vous recommandez un restaurant à un ami sans jamais y avoir mis les pieds, mais en vous basant juste sur les avis que vous avez lu dans un guide de restaurants. Si c’est un guide facile à manipuler, vous éviterez certainement de le faire. Si c’est un guide renommée, fiable et qui a déjà fait ses preuves, pourquoi pas. Après tout, si une source de confiance recommande une adresse, pourquoi ne pas la recommander à votre tour ? Vous pouvez également être amené à conseiller un restaurant en vous basant juste sur les avis dont vos collègues ou amis vous font part régulièrement : si on vous parle de cette adresse quasiment chaque semaine et qu’on vous dit que c’est excellent, c’est que le restaurant en question doit vraiment être bien et qu’il y a très peu de chances qu’il soit fermé (404). Si en plus vous passez devant tous les jours, que c’est toujours plein et que les gens en sortent avec le sourire, alors pourquoi ne pas le conseiller vivement … tout en indiquant que vous n’y êtes jamais allé (d’où le message « La description de ce résultat n’est pas accessible à cause du fichier robots.txt de ce site »).

On voit parfois des cas très étonnants de pages, parfois de sites tout entiers, qui sont en disallow et qui obtiennent d’excellentes positions en résultats naturels. Une des explications la plus probable est que de nombreux liens fiables y font référence (une ressource bloquée au crawl accumule tout de même du Page Rank) et ou peut-être par ce que Google, au travers de ses nombreux mouchards, sait que le trafic qui y tombe est qualifié et « capté ».

J’avais remarqué ce genre de phénomène en préparation de mon voyage à Dubai. J’avais lancé une recherche sur « hotel dubai » et le second résultat sur cette requête concurrentielle… était une page de l’office du tourisme dubaiote bloquée au crawl par le robots.txt ! Les liens qui pointaient vers cette page, internes comme externes, devaient lui apporter tellement de crédit et « porter » tellement de sémantique (sémantique déportée) que Google a décidé de la faire sortir en seconde position. En tout cas c’est mon interprétation de la chose.

Ces pages bloquées sont donc indexées :

- Sans avoir été crawlées

- Ou en ayant déjà été crawlée mais n’étant plus crawlable depuis la dernière mise à jour de votre robots.txt

Si c’est le cas, ces pages seront présentées dans les SERP sous une forme clairement identifiable :

- Le Title est un titre fabriqué par Google à partir de tout ou partie des éléments externes à la page (ancres de liens pointant vers la page, contenu des pages lui faisant des liens, …)

- La Meta Description (jusqu’à récemment pas renseignée par Google, mais on m’a montré un cas étonnant il y a peu) est remplacée par une phrase explicite : « La description de ce résultat n’est pas accessible à cause du fichier robots.txt de ce site ».

Le fait que Google n’affiche généralement pas de description se comprend aisément :

- Les ancres de liens ne sont que rarement des phrases complètes et « parlantes » et ne peuvent donc servir à constituer une description

- Afficher une description constituée des contenus des pages qui lui font un lien porterait à confusion

- Google n’ayant pas accès au contenu de cette page (si elle n’a jamais été crawlée), il ne se risquera pas (en tout cas pas pour l’instant) à lui rattacher un résumé

Encore une fois j’ai eu un contre exemple il y à quelques semaines. La Meta Description affichée dans les SERP était ajoutée par Google. Je n’ai par contre pas analysé pour savoir si cette description venait d’antiques annuaires tels que DMOZ par exemple. Si vous avez des cas intéressants à analyser, n’oubliez pas que les commentaires sont faits pour ça ;)

Possibilités offertes par le robots.txt

Vous allez penser que j’aime me couper les cheveux en quatre (bon j’avoue c’est le cas) mais si la fonction primaire du robots.txt est de gérer le crawl du site, ce fichier peut également contenir des directives de non indexation…

Je vais ici parler de « ressource » pour désigner tout contenu d’un site, que ce soit une page HTML, une image, un PDF, un document Word, un dossier complet, …

Possibilité 1 : interdire ou autoriser le crawl d’une ressource

Les directives « Disallow » et « Allow » agissent en effet directement sur le crawl et n’ont pas d’influence directe sur l’indexation.

Ainsi, on ne peut pas (on ne peut pas, c’est impossible, pas la peine d’essayer, ça ne marche pas, it doesn’t work, funktioniert nicht) désindexer un contenu en lui appliquant une directive Disallow. Cette dernière ne fera qu’empêcher son crawl par Google mais comme évoqué ci-dessus, rien ne lui empêche de le présenter tout de même dans les SERP. Pour supprimer une page de l’index, il faut en faire la demande dans Webmaster Tools, renvoyer un 4xx ou 5xx, ou se faire blacklister, mais c’est plus difficle.

Disallow: sert donc à interdire le crawl d’une ressource.

Nan mais Allow

Allow: (nan mais Allow quoi) permet d’annuler le Disallow pour la ressource visée. A ma connaissance, tous les moteurs de recherche ne supportent pas cette directive, faites donc attention. C’est assez dommage car les direcitves Allow sont très pratiques. Elles ouvrent beaucoup de possibilités. Vous en trouverez des exemples dans les « trucs et astuce » plus bas dans cet article.

Au final c’est assez simple : Disallow, j’interdis le crawl. Allow, j’autorise le crawl.

Possibilité 2 : interdire l’indexation d’une ressource

La directive Noindex porte bien (mieux) son nom et est assez claire : elle sert à dire à notre cher Google, « Google, n’indexe pas ceci » porte mal son nom. « Noindex » veut bien sur dire « n’indexe pas ceci » mais aussi « ne crawle pas non plus cette ressource » . N’étant pas une directive supportée officiellement, elle peut être supprimée du jour au lendemain, mais j’en doute.

Comme le Disallow, cette commande étant une directive, elle est suivie à la lettre.

Bon à savoir, Allow: l’emporte sur Noindex: mais sur ses deux dimensions : gestion du crawl ET gestion de l’indexation.

Possibilité 3 : déclarer des sitemaps

La dernière possibilité offerte par le robots.txt est d’indiquer l’URL des sitemap XML ou texte destinés aux moteurs de recherche.

La syntaxe

Documentation officielle

Rien de mieux et de plus précis que de vous renvoyer vers la doc Google à ce sujet.

Je me contenterai de déplorer deux choses :

- Autant il existe bien Allow et Disallow, autant je regrette l’absence de la commande Index pour annuler une directive Noindex

- Il aurait bien été mieux, mais plus risqué, de permettre l’usage de regex pour les directives, plutôt que la syntaxe bizarre qui a été définie. Si quelqu’un de chez Google lis ça un jour… C’est bientôt mon anniversaire on ne sait jamais :)

Quelques exemples d’utilisation du robots.txt

Interdire le crawl des pages /contenu et des pages /contenu/toto mais pas des pages /contenu/ (avec slash final) :

Disallow: /contenu Allow: /contenu/$

Interdire le crawl et l’indexation de la pagination (attention aux autres paramètres éventuels…) pour des pages avec p= :

Noindex: /*?parametre=

Interdire le crawl et l’indexation des pages avec tracking (attention aux autres paramètres éventuels…) :

Noindex: /*?utm_*=

Autoriser le crawl de la page 527.html en interdisant toutes les autres 5xx.html (encore une fois faites très attention à ce qui peut matcher) :

Disallow: /5*.html Allow: /527.html

La directive suivante n’interdit à Google Bot que le crawl du dossier /site/ (le wildcar ne s’applique pas à lui) :

User-agent: Googlebot Disallow: /site/ User-agent: * Disallow: *

Etc.

Et ça fonctionne vraiment ? Est-ce fiable ?

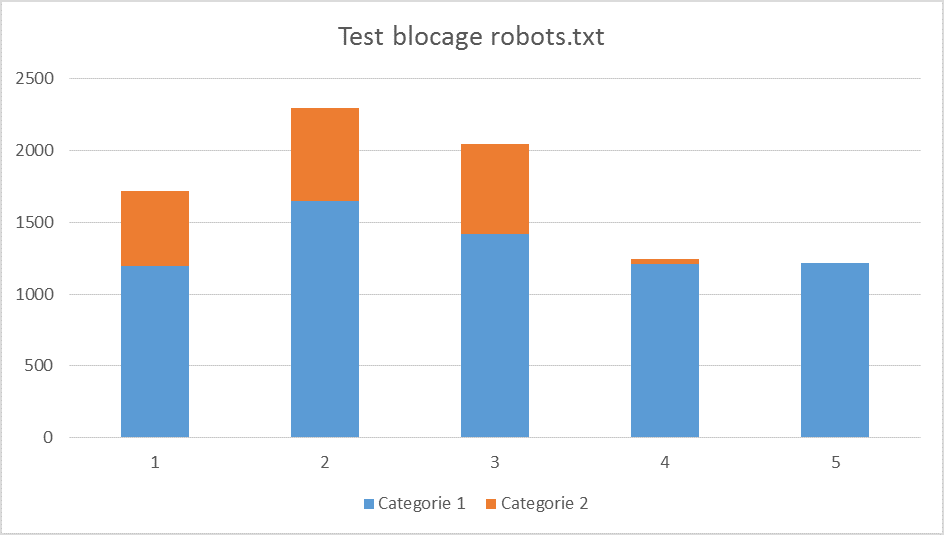

Oui. Google applique à la lettre les directives. Voici un petit exemple fait sur une section d’un de mes sites perso, sur lequel Google s’est mis à crawler des pages résultant d’un bug technique. Voici un extrait des hits de Google bot sur ces pages (en orange) et sur une autre typologie de pages. J’ai fait un focus sur 5 jours juste pour montrer l’effet.

Une règle disallow a été mise en place pour bloquer le crawl des pages de catégorie 2 en fin de journée jour 3 sur le graph. Résultat :

Fiabilité du robots.txt, démonstration

La baisse du nombre de hits sur les barres bleues n’est due qu’à de la fluctuation normale. Pour ce qui est de la partie orange par contre, le résultat est bien visible. Dès que Google a pris en compte la règle disallow, le crawl sur ces URL est stoppé.

Si votre page est bloquée par robots.txt mais qu’elle est indexée et présentée avec un son propre Title et sa Meta Description, encore plus s’il existe une version en cache et sauf si vous êtes dans le cas évoqué à l’instant, c’est que :

- Soit vous avez fait une erreur de syntaxe dans votre robots.txt (c’est extrêmement fréquent !)

- Soit vous n’avez pas mis le robots.txt à la racine de votre site

- Soit vous avez fait une erreur dans le nom de fichier (je l’ai déjà vu !)

- Soit Google n’en a pas encore pris connaissance (une astuce plus bas dans cet article)

- Soit Google ne peut pas accéder à votre robots.txt (4xx)

- Soit … il faut mettre un exemple en commentaire à cet article ;) Mais soyez précis

Google peut également crawler une page … et ne pas l’indexer

On parle maintenant de l’exact inverse : une page crawlée par Google mais qui n’est pas présentée dans l’index.

Il y a tout un tas de raisons pour lesquelles Google peut crawler une page sans toutefois l’indexer. Ce n’est pas l’objet de cet article mais parmi ces raisons on trouve bien sur une directive noindex, URL canonique différente de l’URL de la page en question, un code différent de 200, un contenu de très faible qualité (« spam pur » selon Google, ou très forte duplicaiton de contenu), …

Trucs & astuces sur le robots.txt

- Le wildcar doit toujours être placé à la fin, en théorie. Dès qu’on spécifie le nom d’un User-agent, toute directive qui suis s’y applique, et uniquement celles-ci.

- Un fichier robots.txt doit faire moins de 500kb (soit 62 ko) pour Google. Toute directive entrée au delà de cette limite sera ignorée

- Toute entrée située dans L’entrée « User-agent » ainsi que les directives et URL sont, en théorie, sensibles à la casse.

- Le fichier doit être un fichier plain/text encodé en UTF-8 (pour l’encodage, ce n’est vraiment impactant que dans le cas de l’utilisation de caractères spéciaux). Par contre je n’ai aucune idée de comment on fait avec des URL écrites en caractères exotiques (par exemple Japonais ou Chinois. Est-il possible d’encoder le robots.txt en UTF-16 ? Si quelqu’un a la réponse, son commentaire est le bienvenu (Philippe Yonnet, si tu passes par ici ?)

- Couper au crawl une page en structure ou maillée depuis l’extérieur revient à détruire du PageRank (à relire et méditer 3 fois, puis à relire, et à méditer encore)

- La directive Crawl-delay: ne fonctionne pas sur Google. Elle est d’ailleurs souvent incomprise : la valeur indiquée correspond au nombre de hits autorisés par seconde sur le site. Ainsi, lorsque certains webmaster se disaient qu’ils voulaient espacer les hits de Bingbot de 10 secondes sur leur site, ils demandaient en réalité au robot de venir 10 fois par seconde. Avouez que c’est ballot :)

- Le dollar permet de terminer la règle. Il a la même fonctionnalité qu’un dollar dans une regex. Pour vous en souvenir, voici mon moyen mnémotechnique : on sors les billets à la fin, pour payer la note.

Warnings et erreurs courantes

Le robots.txt ayant pour utilité de gérer le crawl, il faut impérativement faire très attention à ce que vous en faites. Cet outil est aussi puissant (pour le crawl, et dans le cas des directives Noindex pour la désindexation) que dangereux (pour votre Pagerank).

Maniez le avec précautions. J’ai moi même un jour, par erreur, bloqué au crawl plus de 5000 URL présentes en structure… en ayant simplement oublié un $. A méditer !

Voici quelques erreurs à éviter :

- Modifier le robots.txt et penser que, par magie, Google aura immédiatement pris en compte ses modifications. Ne pas oublier que Google a besoin de recrawler le robots.txt pour prendre en compte les modifications (fat Matt parle d’une mise en cache côté Google de plus ou moins 24h mais j’ai plutôt un avis différent sur la question). Cela veut dire qu’on doit passer un robots.txt impactant bien avant une mise en prod qui ajoute des pages qu’on doit potentiellement bloquer

- (Balise meta robots noindex ou X-robots-tag noindex) + blocage robots.txt = Google, peux-tu (not provided) cette ressource s’il te plait ? En clair, Google ne pourra pas voir la noindex puisqu’il ne pourra pas crawler la page. C’est comme demander à votre femme d’aller à la maison pour trouver votre portefeuille : si elle n’a pas la clé elle ne pourra rien voir. Bon, remarquez, quand je le demande à la mienne, même avec la clé elle, ne le trouve pas… mais c’est une autre histoire.

- Faites attention à la casse dans les règles. Disallow: /f/ ne bloque pas /F/

Notes, références et lecture complémentaire

- Vous trouverez sur le site de Google des explications claires sur le fonctionnement du robots.txt et sa syntaxe

- Egalement, la liste des UA des crawleurs de Google

- Vous trouverez sur ce site un validateur de robots.txt très utile, qui permet d’en contrôler la syntaxe

- Pour contrôler ponctuellement si un contenu est ou non bloqué au crawleur Googlebot par une directive du robots.txt, utilisez, par exemple, la fonction Explorer comme Google de Google Webmaster Tools

- Une vidéo du gros Matt qui explique qu’une page bloquée par robots.txt accumule du PageRank

- Une interview intéressante de Matt Cutts sur le robots.txt et le noindex chez StoneTemple

C’est tout pour aujourd’hui, j’espère que cet article vous a plu.

Abonnez-vous au flux flux RSS | You can skip to the end and leave a response. Pinging is currently not allowed.

Bjr

Merci pour cet article.

Je dois être un peu bigleux :-) mais je ne vois pas de fil RSS pour ce blog. C’est normal ou il faut « deviner » l’URL (http://www.nicemedia.fr/blog/feed) ?

merci

a+

500ko le robots.txt, il aimeleslootres pour faire cette taille non ?

J’avais vu 62ko (soit 500kb/8).

J’étais sur que j’allais apprendre quelque chose :) En effet c’est bien des kb, donc 500 kb => 62 ko. La nuance est de taille ! Merci pour l’info je modifie.

En fait ta remarque concernant le portefeuille et la clé est fausse car Google peut trouver une page liée de l’extérieur et donc pour la crawler il ne vas regarder Robots.txt c’esrt pourquoi John Muller suggère d’utiliser les 2 en même temps.

Google Dit « Remarque : Même si vous utilisez un fichier robots.txt pour empêcher que les robots n’explorent du contenu de votre site, Google peut détecter le contenu par le biais d’une autre source et l’ajouter à l’index. » Source https://support.google.com/webmasters/answer/93708?hl=fr

Bonjour Mohammed,

Tu devrais relire l’article. Nous sommes tout à fait d’accord sur le fait qu’une page peut avoir des liens externes mais ça ne change rien au fait que Google peut la découvrir et la crawler sauf si le robots.txt l’en interdit. Si c’est le cas, elle pourra bien sur être indexée comme je l’ai dit dans l’article.

Google respecte le robots.txt dans tous les cas si la syntaxe est correcte, que l’URL ait été trouvée via des liens internes ou externes.

François-Olivier

Bonsoir, François-Olivier,

Je ne sais pas comment ça se passe avec des langues exotiques, mais pour ajouter des urls cyrilliques (le cas de la langue russe) dans un robots.txt on doit absolument passer par un convertisseur Punycode.

Tiens, je ne connaissais pas la directive noindex. Donc, merci:)

J’ajouterais aussi l’importance de bien appeler les bots. Mon ex-collègue utilisait tout le temps « Google » au lieu de « Googlebot » ce qui lui a fait naître beaucoup de fausses conclusions.

Bonne journée a toi!

Cordialement,

Alexis.

Merci pour la précision et pour ton message concernant ma coquille sur le user agent (j’avais indiqué Google-bot et non Googlebot). C’est corrigé ;)

Bonnes fêtes

Je n’ai jamais rencontré ton cas de figure ou une page en disallow ressort en première page. Ça doit rester un cas isolé.

Par contre pour tout ce qui est noindex, Google conseille quand même plutôt d’utiliser la meta noindex ou l’en-tête HTTP x-robots-tag.

Je cite une ressource intéressante supplémentaire : https://support.google.com/webmasters/answer/156449?hl=fr

Bonjour Jérôme,

C’est n’est pourtant pas rarissime. Pendant quelques mois Chronodrive a été présenté en 1ère page alors que tout le site était en disallow (enfin, les quelques pages crawlanbles). Ca m’arrive plusieurs fois par mois. Pour ce qui est de noindex ou x-robots-tag oui Google le recommande et le supporte officiellement. Ils ne conseillent pas forcément de l’utiliser dans le robots.txt car c’est une fonctionnalité non officielle. Pour ma part je l’utilise dans le robots.txt soit quand c’est bien plus facile et rapide, soit quand il est techniquement impossible ou peu ROIste de faire la modif au niveau Apache ou du code (x-robots-tag) voire du template (meta robots).

Ca fait du bien de lire un article sans conneries sur le robots.txt :-)

Tu as testé la directive Nofollow ? Ca fonctionne ? Ca bloque bien crawl + indexation ?

PS : faudrait que tu ajoutes le plugin pour pouvoir être informé des nouveaux commentaires.

Hello JB,

Merci pour ton passage et ton commentaire.

Tu voulais parler de la directive Noindex non ?

Ca ne bloque que l’indexation, pas le crawl. Je m’en sers parfois en combinaison avec un Disallow, quand c’est nécessaire.

Par contre tu disais à ta formation que le noindex permettait de freiner le crawl, il faudrait que je refasse le test car je n’avais pas eu ce résultat. J’ai du foirer quelque chose quelque part. Et c’est aussi suite à ta formation que j’ai eu envie de finir cet article ;)

A bientôt

PS : pour le plugin, tu en aurais le nom ?

Je parlais bien de no-index (dur le retour de vacances).

L’extension est http://wordpress.org/plugins/subscribe-to-comments/

Ok, c’est installé merci ;)

Je découvre ton article avec pas mal de retard suite à ton tweet d’hier. Très bien cet article d’ailleurs ! Nous sommes nombreux je pense à avoir du mal à expliquer aux gens la différence entre crawl et indexation, entre disallow et noindex.

Petit détail, tu écris :

« on ne peut pas (on ne peut pas, c’est impossible, pas la peine d’essayer, ça ne marche pas, it doesn’t work, funktioniert nicht) désindexer un contenu en lui appliquant une directive Disallow. »

Pourtant, Google propose de désindexer une page via GWT simplement en la bloquant au crawl (et en faisant une demande manuelle de désindexation). C’est incohérent et contredit le message général sur les différences entre crawl et indexation, mais c’est tellement pratique (pour les cas où l’ajout d’un noindex est difficile) que Google le laisse je suppose.

Concernant le crawl-delay, je crois bien que tu te trompes. En tout cas Bing précise très bien les choses : plus la valeur est élevée, plus le crawl est ralenti : http://blogs.bing.com/webmaster/2009/08/10/crawl-delay-and-the-bing-crawler-msnbot/

Merci pour toutes ces précisions, autant dans l’article que dans les commentaires. C’est toujours bon de refaire le point. !

Ce matin j’ai vu un robots.txt qui m’a bien fait rire, je le partage donc : http://www.google.com/killer-robots.txt

@Olivier, et moi je valide ton commentaire avec 8 mois de retard ^^

Où indiques tu à Google, dans WMT, de désindexer une page en « la bloquant au crawl » ?

Fais tu référence à ceci http://www.nicemedia.fr/blog/articles-referencement/url-a-supprimer-cette-fontion-wmt-qui-ne-fonctionne-pas-comme-vous-le-pensiez ? Auquel cas ce n’est pas ce que Google dit ;)